Como director de fotografía siempre he intentado tener el mayor control posible de la imagen que creo y el sencillo artículo que llega a sus manos es el resultado de ese intento después de años de leer y aprender a manejarme en los entornos digitales, algo que sinceramente no sé si aún he conseguido. Vayan pues mi inquietud sobre el Sistema de Zonas compartidas en este texto.

El sistema de zonas de la fotografía analógica en la cinematografía digital

Por Alfonso Parra AEC, ADFC

A menudo escucho relacionar el sistema zonal, ideado por Ansel Adams y Fred Archer con la imagen digital y en este artículo me propongo reflexionar hasta donde esta relación es válida y transferible de un sistema a otro, concretamente en el mundo cinematográfico. Para comenzar recordemos que el sistema de zonas no solo abarca la medición y la exposición de la escena, sino que es un proceso completo que incluye el estudio del material negativo y positivo además de los revelados quimicos de cada uno de ellos.

El sistema pone en relación la luminancia de la escena con los valores de luminancia de la copia positiva pasando por la densidad del negativo una vez expuesto. El objetivo del sistema de zonas, en definitiva, es poder prever los resultados en la copia positiva de la imagen surgida del negativo después de su exposición, relacionando los contrates de la escena con el contraste final en la copia. El sistema de zonas se puede definir de tres sencillas maneras (1):

1- Valores de la copia positivada. Cada zona (numeradas del 0 al IX) simboliza un tono distinto de luminosidad en el positivo que va desde el negro, pasando por los grises y terminando en los blancos (todo esto referido a las copias en blanco y negro). Así, por ejemplo, la zona 0 representa el negro, la zona V representa el gris medio del 18% y la zona IX representa los valores de blanco del 90%. Estas zonas están relacionadas con la luminancia de las zonas medidas en la escena (Figura 1)

2- Cada zona revela no solo valores de luminancia distintos sino la cantidad de detalle y textura que podemos ver. De esta forma asociamos a cada zona objetos que suelen aparecer con frecuencia en las mismas. Por ejemplo, el pelo oscuro se encuentra en la zona III o la nieve en la zona VIII.

Figura 1

3- Las zonas se pueden medir de forma sencilla mediante un spot meter y expresar en relaciones de cd/m2, números EV o calculado en F stop.

Cuando tanto el negativo como el positivo se revelan de forma “normal” y se ajustan a sus respectivas latitud cada zona corresponde a un paso de stop de exposición.

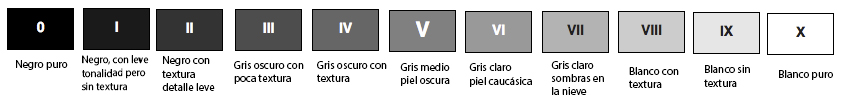

Figura 2

Según el esquema (figura 2), los valores de luminancia de distintas zonas de la imagen quedan, mediante la exposición, capturadas en el negativo en forma de densidades, densidades que dependen no solo de la intensidad de la luz que llega al negativo sino también de la gamma con la que esté construida la emulsión y del proceso de revelado. Durante el proceso de positivado, esas densidades son proyectadas sobre el soporte positivo; la imagen obtenida dependerá del tiempo de exposición, del positivo, su gamma y su proceso de revelado. Finalmente podemos establecer una relación si todo el proceso está estandarizado entre los valores de luminancia de la escena y la del positivo fotográfico. El sistema en sí mismo permite tener una idea de cómo será el resultado final en la copia cuando se realiza la fotografía, considerando las distintas mediciones de la luz reflejada en las diferentes zonas de la escena.

Claro está, que todo este sistema esta sujeto a un proceso de estandarización, pues cualquier cambio, en la emulsión, procesos de revelado (químicos, tiempos y temperaturas) o en el soporte mismo positivo (distintos fabricantes, distintos contrastes, etc.) conlleva un cambio de la distribución de las zonas. En el mundo cinematográfico el proceso está muy estandarizado, con menos emulsiones que el mundo de la fotografía y con condiciones de revelado y positivado más generalizados, además con apenas unos poco positivos a elegir.

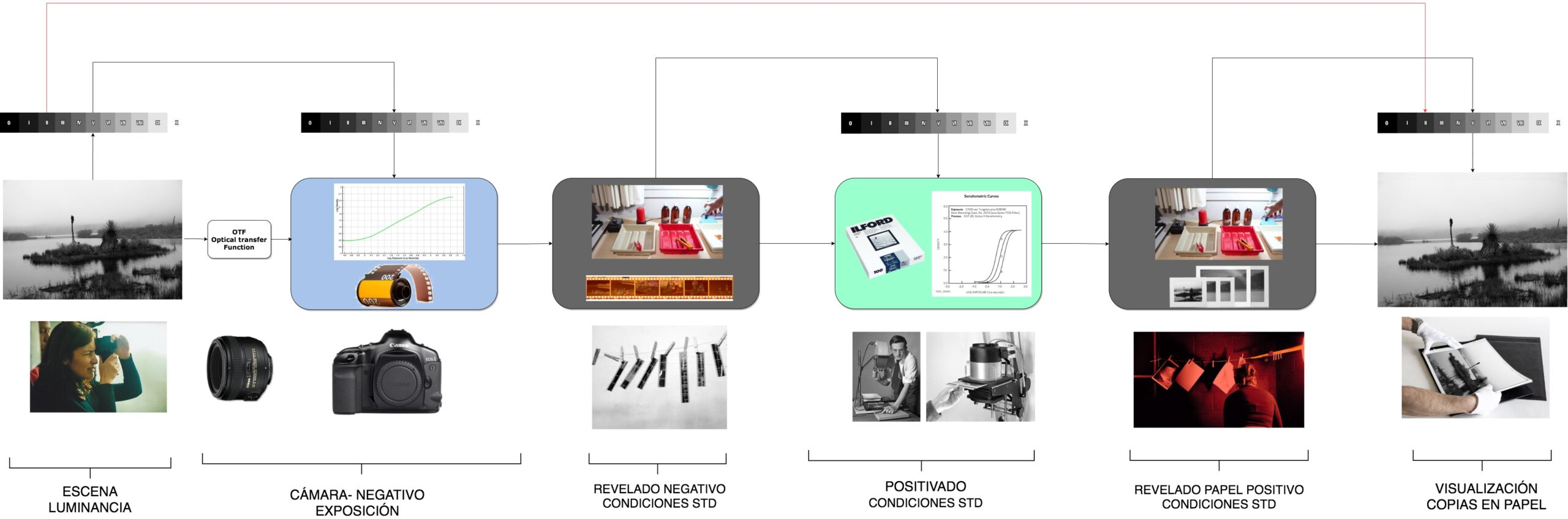

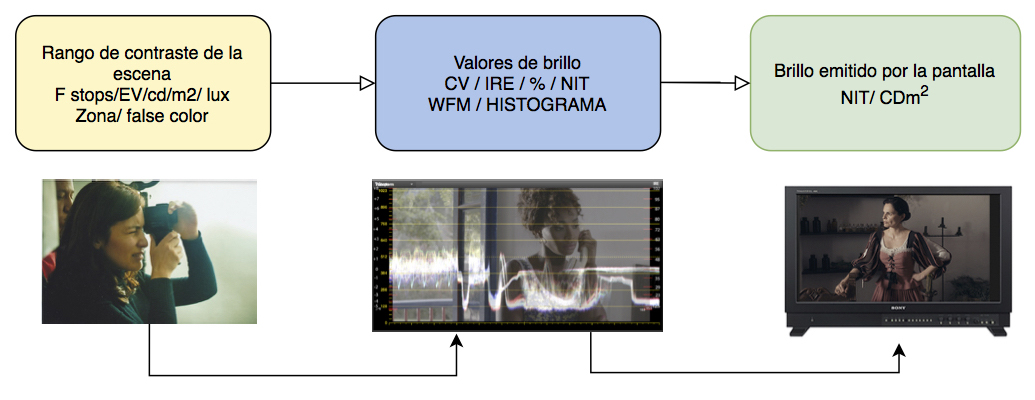

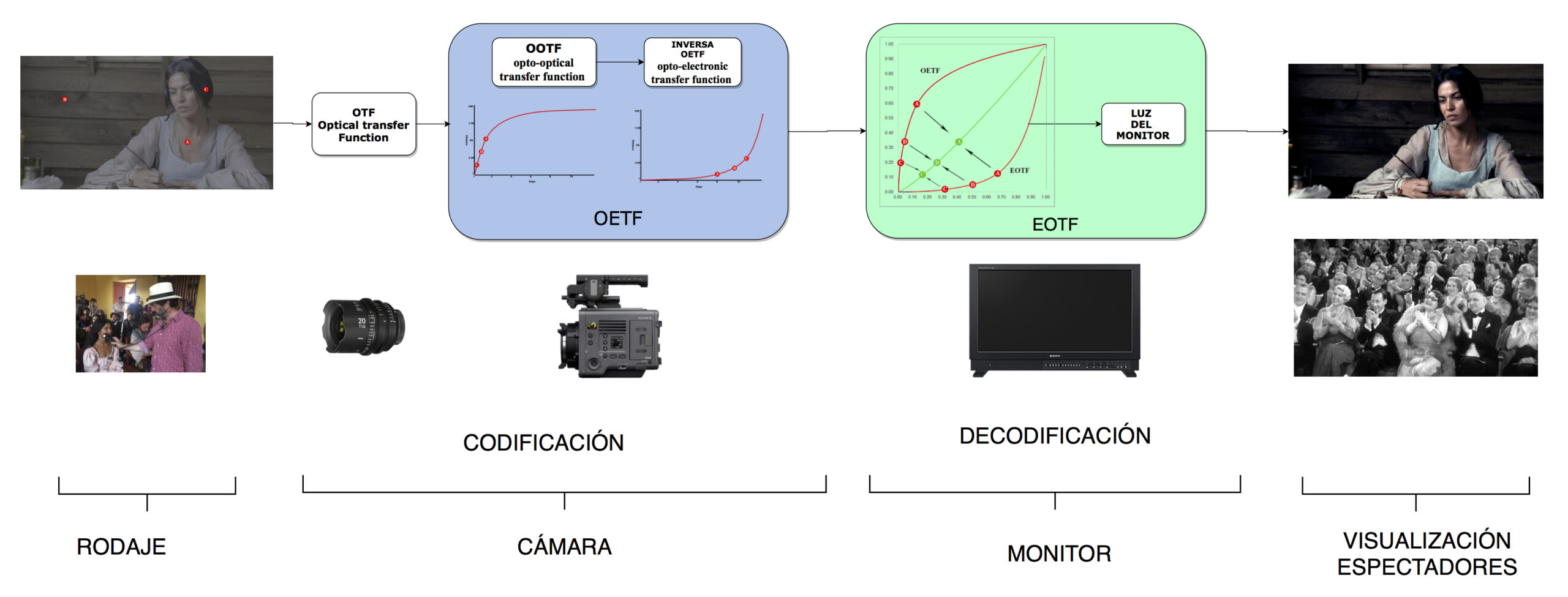

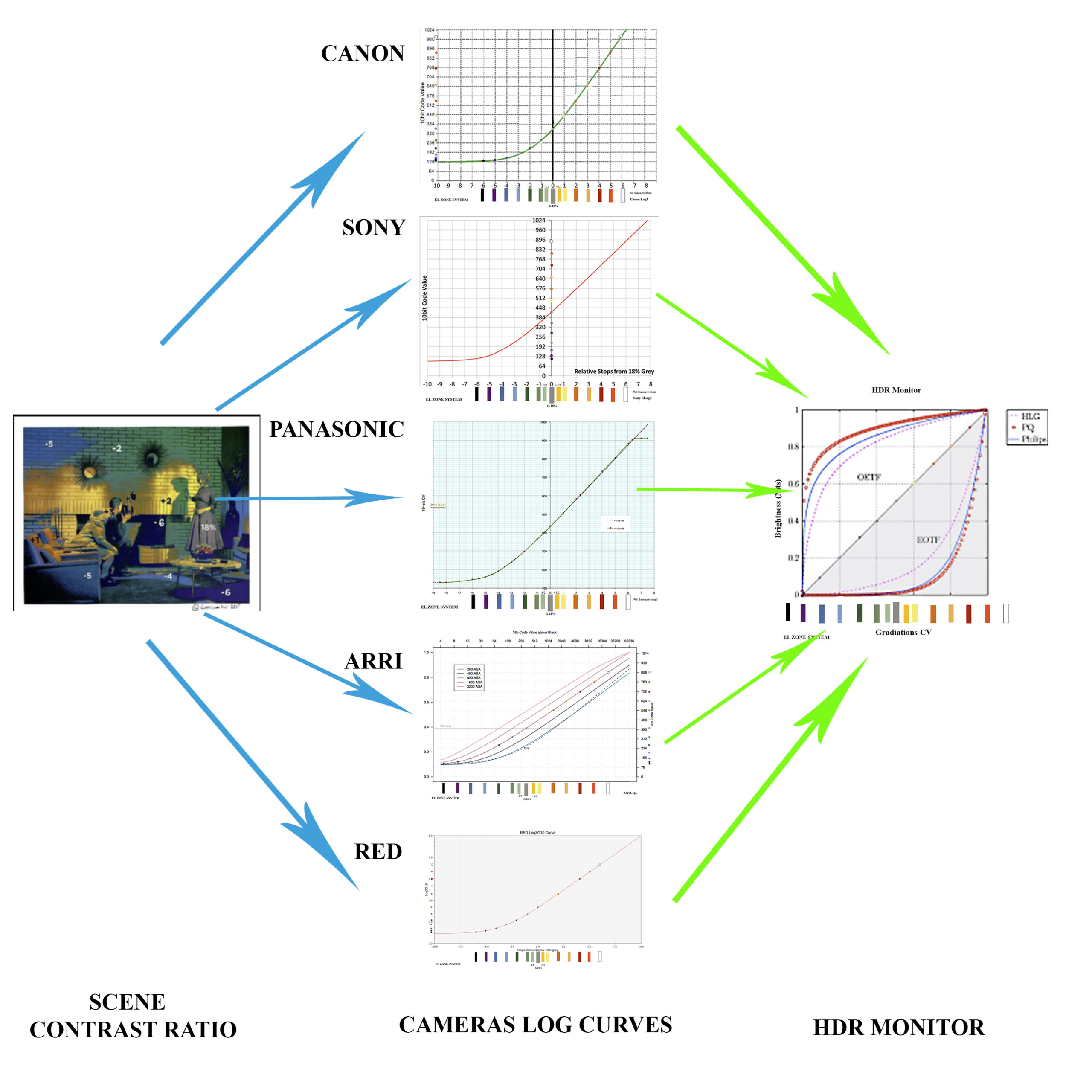

Si queremos o necesitamos replicar este sistema en el mundo digital (figura 3), tendríamos que relacionar el ratio de contraste de la escena en relación a la curva de gamma utilizada en la cámara, los cv (en valores decimal RGB) de la imagen, así como el valor de brillo (nit) en el monitor o pantalla de proyección de esos cv. Los valores de brillo de la escena que medimos con nuestro spotmeter corresponden a un valor de brillo determinado emitido por el monitor cuando a estos valores se les han aplicado las distintas funciones (gamma, Knee, matrix, iso, etc), considerando igualmente que esos valores de brillo de la escena están en relación con los cv (code value), leídos en el wfm (en modo de señal de video), histograma o false color. Si pudiéramos establecer está relación, midiendo un punto determinado de la escena sabríamos qué valor de luminancia tendrá en el monitor dicho punto y por lo tanto que detalle y textura. Visto de una manera muy sencilla sería algo como el esquema siguiente:

Figura 3

Pero la cosa es algo más complicada, veamos en este gráfico:

Figura 4

En el diagrama de la figura 4 mostramos de forma muy simplificada el sistema HDR con la curva PQ según el documento ITU.F BT.2390-3. El proceso comienza con la iluminación de la escena y el manejo de los rangos de contraste que el director de fotografía establece. Los valores que usamos para el expresar el rango de contraste pueden ser F stop, o cd/m2 o lux (según el tipo de medición que hagamos, reflejada o incidente) y podemos, como veremos más adelante, hacerlo también en las nomenclatura de zonas o en los colores del false color. La lente es la primera herramienta por la que pasa la luz que viene de la escena; esta proyecta sobre el sensor un círculo de imagen. Esta transformación primera se conoce como OTF (Optical transfer function). Sigue la cámara que convierte la luz proyecta sobre el sensor en valores de brillo digitales lineales que mediante la función OETF (opto-electronic transfer function) hace una distribución de dichos valores de acuerdo a una curva de gamma determinada condicionada también por los ajuste de la función OOTF (opto-optical transfer function) que es una función psicovisual que compensa la diferencia tonal que se da entre el ámbito de la cámara y el ámbito de display garantizando unas imágenes perceptualmente constantes (algo muy importante en HDR). Para ver la imagen debemos aplicar otra función, EOTF (electro-optical transfer function) que convierte esa señal de cámara en la salida lineal de brillos en el monitor.

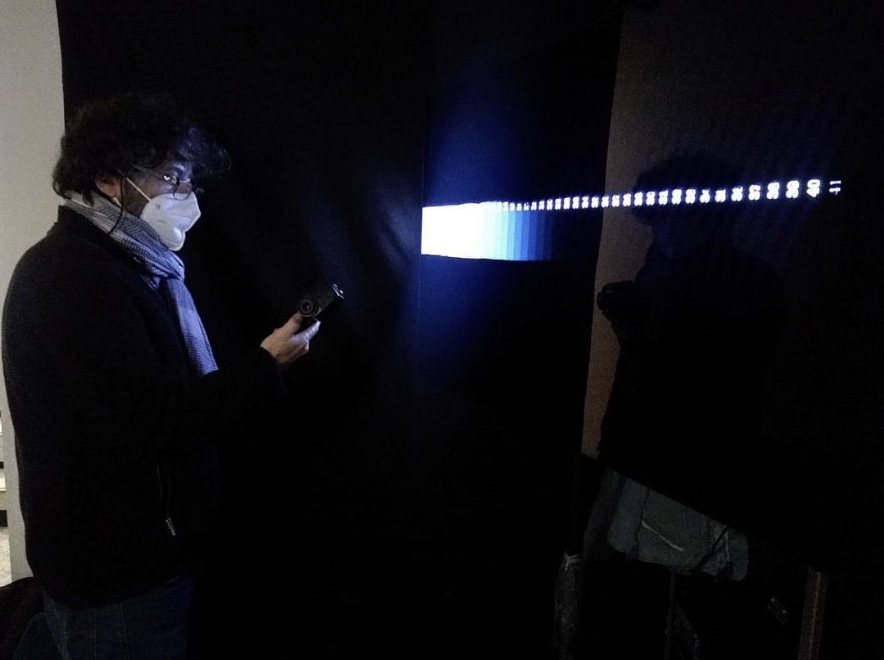

Alfonso Parra AEC, ADFC. Pruebas en FilmFlow

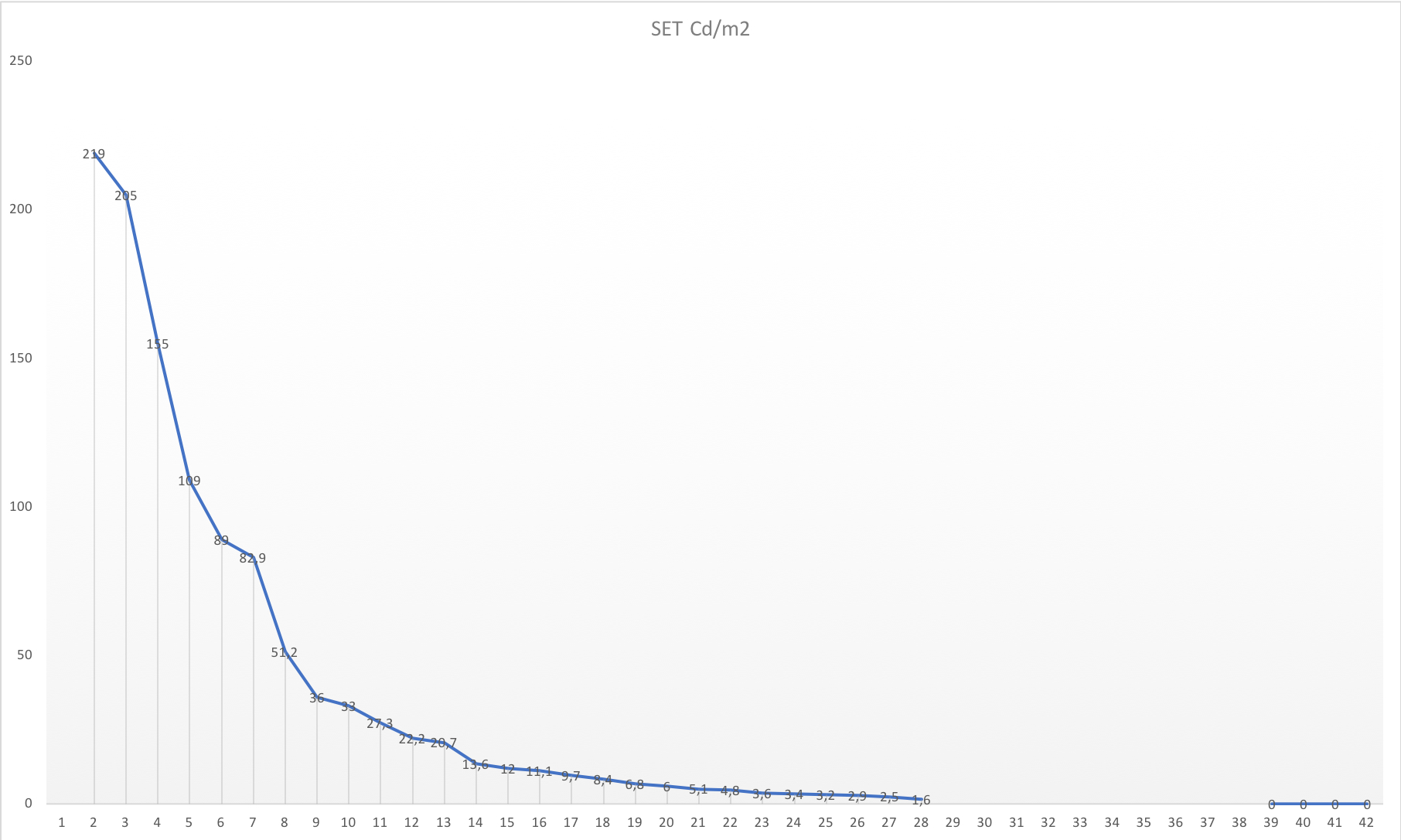

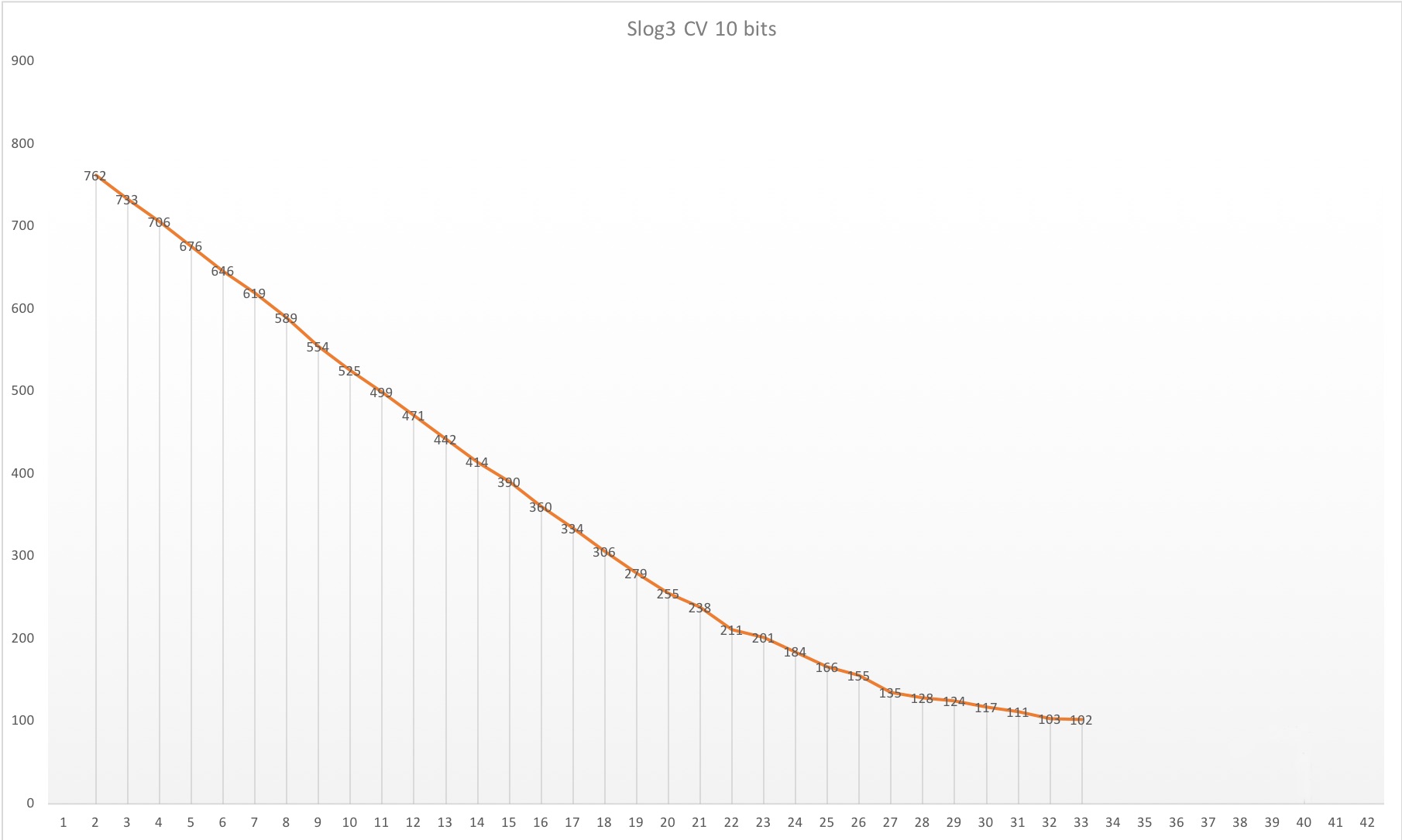

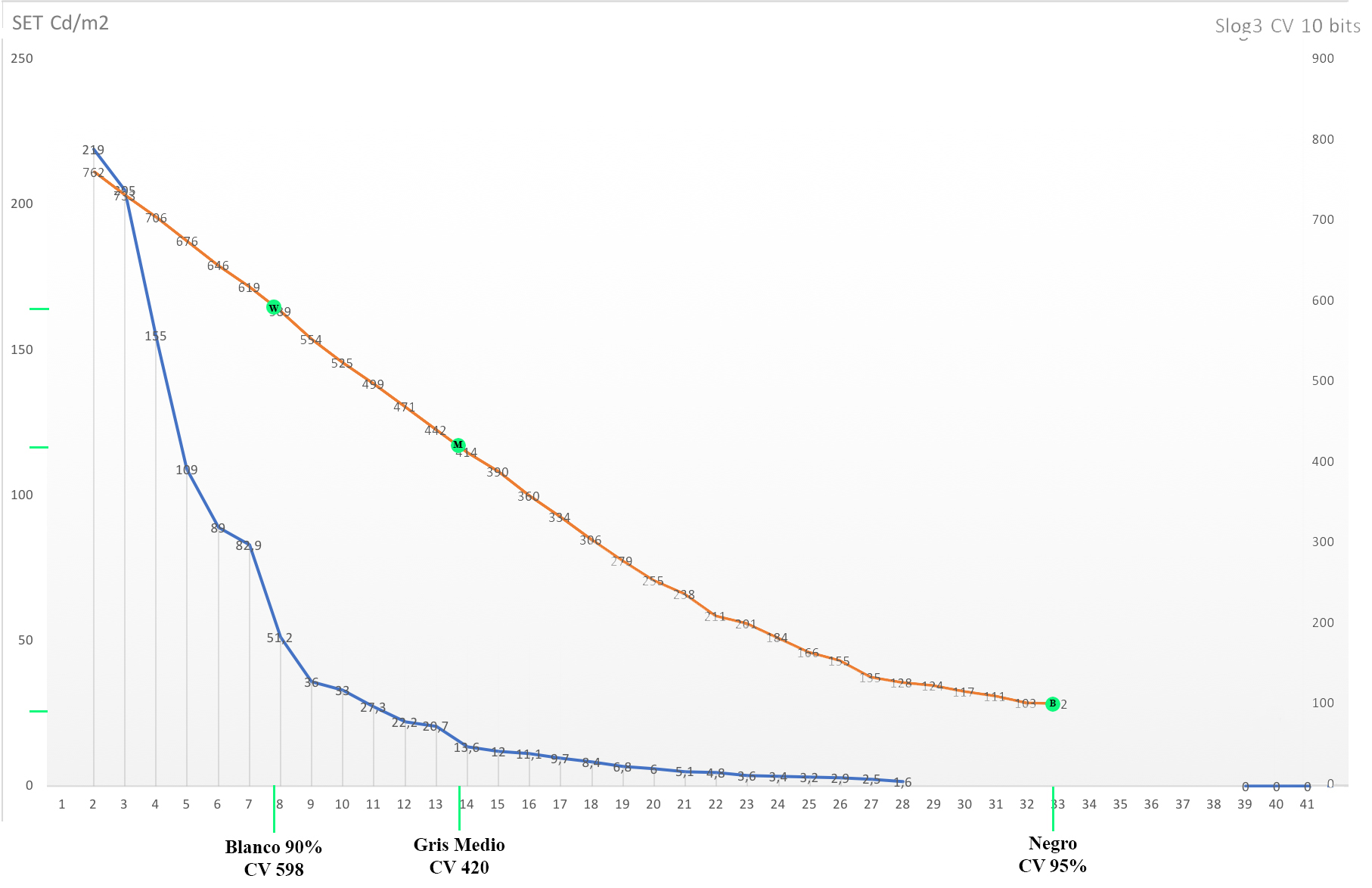

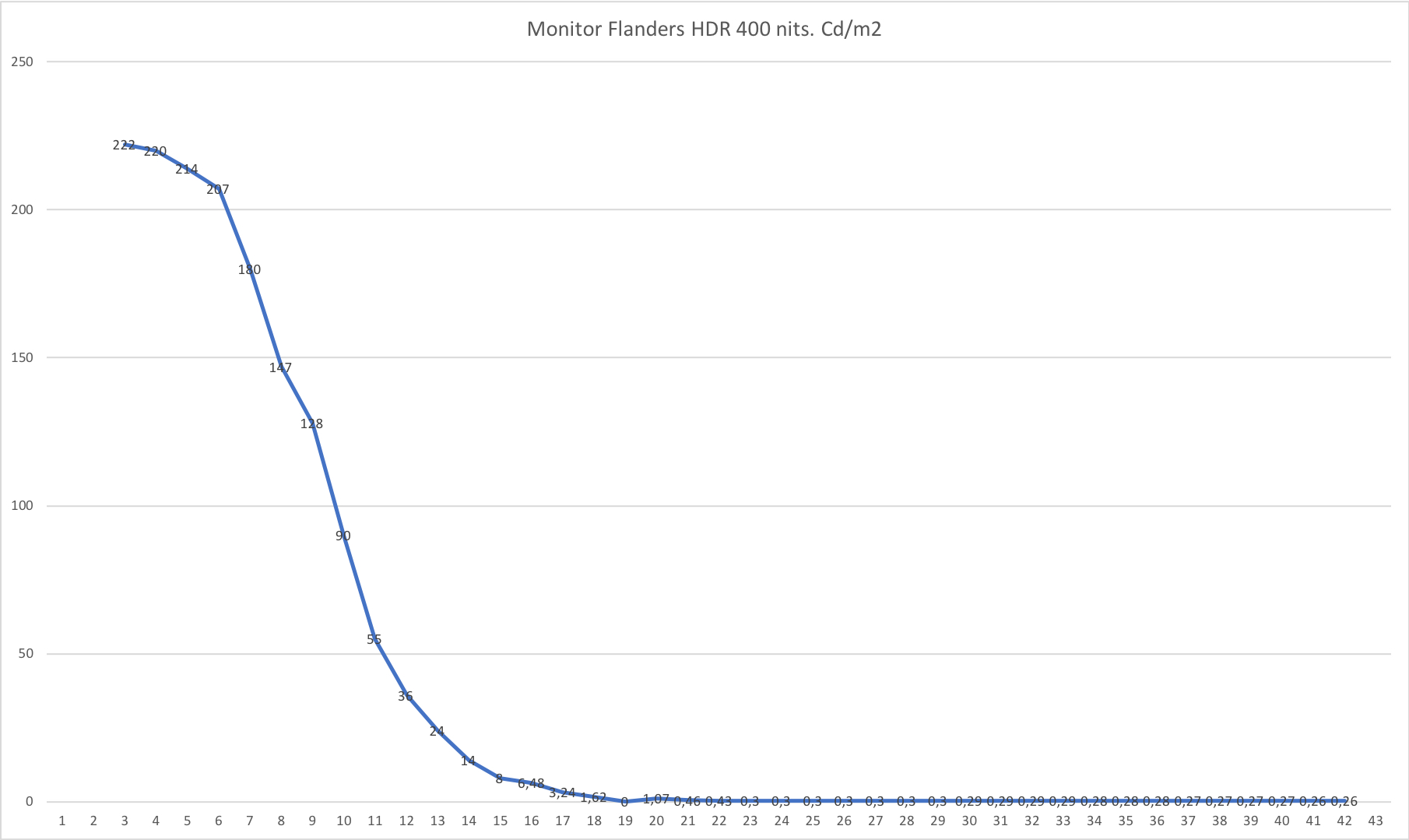

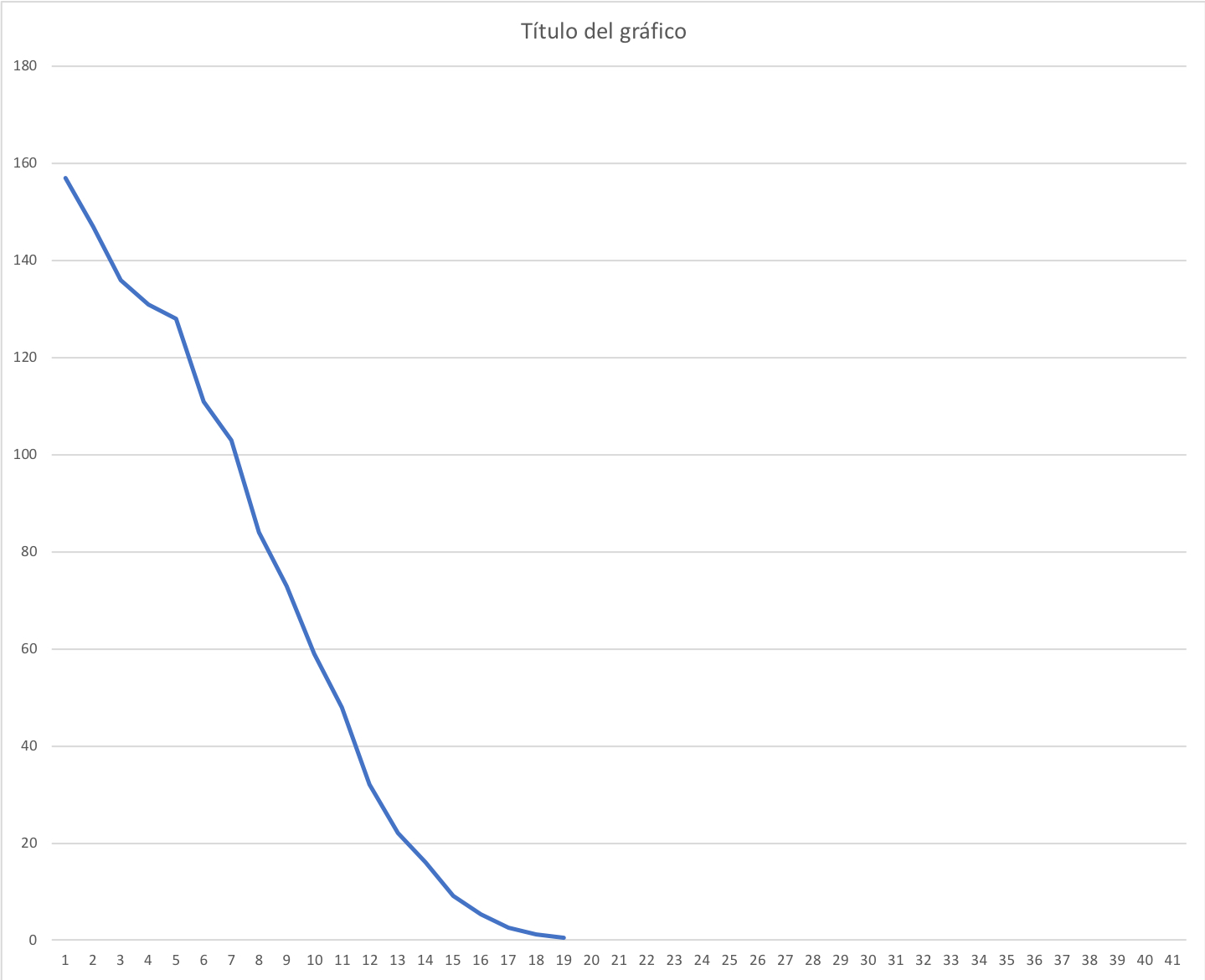

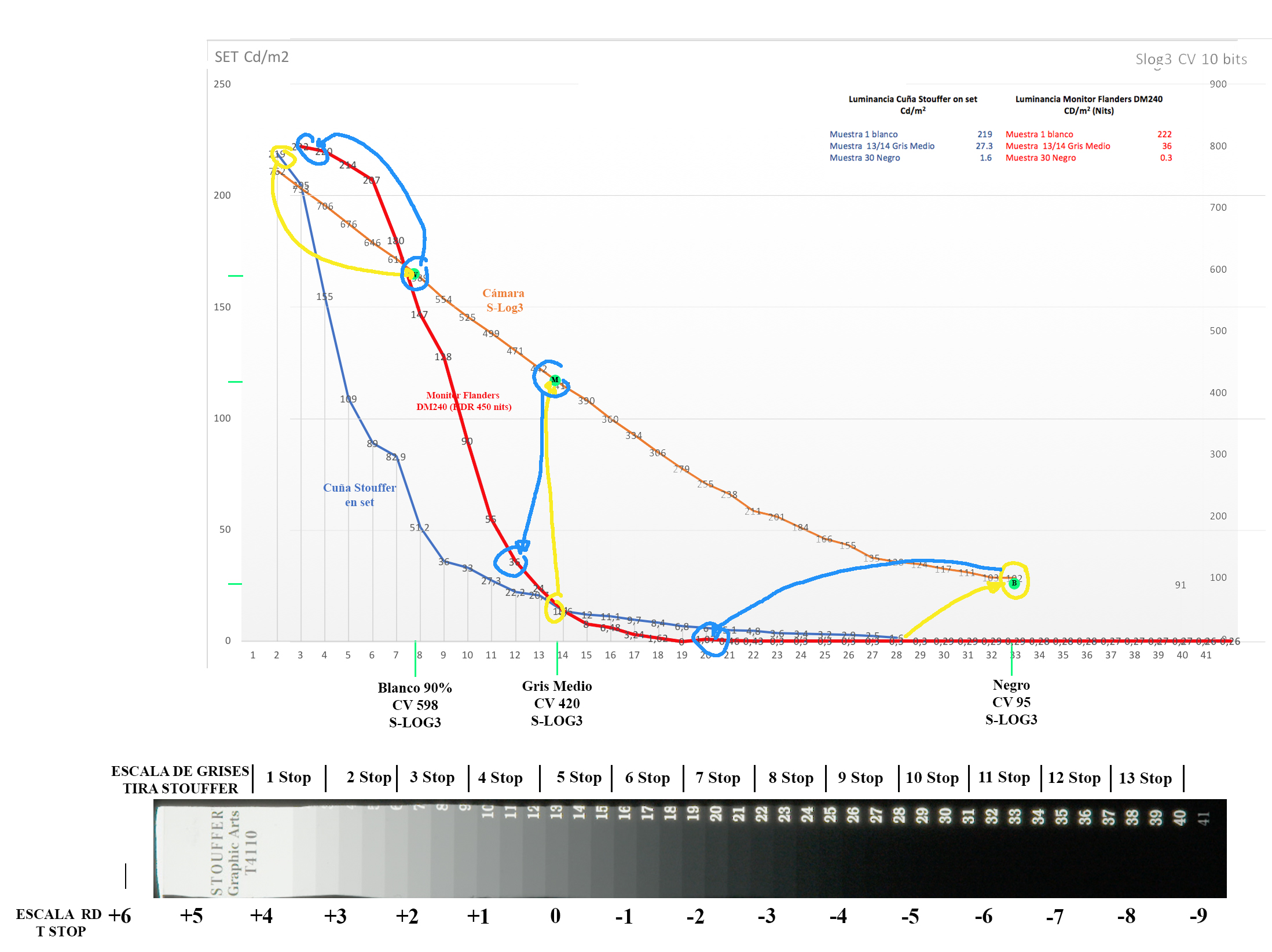

Veamos esta prueba que hemos realizado junto con FilmFlow. Hemos fotografiado una tira stouffer, que es una cuña con 41 valores de densidad calibrada y hemos medido mediante un spotmeter los valores de cada paso en cd/m2 (figura 5). Hemos visualizado el material original con la curva S-Log3 y sobre ella hemos medido los valores cv (figura 6), para luego medir los nits del monitor (flanders DM240 y un televisor Tvlogic HDR) que generaba esa curva con la correspondiente EOTF, de esta manera generamos una tabla que ponía en relación todos los valores.

Figura 5

Esta gráfica representa los valores en cd/m2 medidos con el spotmeter de los pasos de la cuña stouffer.

Figura 6

La figura 6 muestra los cv medidos de la imagen de la cuña con la curva Slog3, de tal forma que los valores cd/m2 se convierten en esos valores de código con esa curva de gamma sobre un espacio Aces, aquí ponemos esa comparación para mayor claridad (figura 7)

Figura 7

Una vez creada el archivo digital con esos valores procedemos a ver como se transforman dichos valores de nuevo en nits (cd/m2) en los sistemas de visualización (figura 8)

Monitor Flanders Nits medidos de la cuña Souffer. Televisor HDR TVLogic. Nits medidos de la cuña Souffer.

Figura 8

Podemos observar las diferencias de valores que se dan de la misma cuña entre el monitor y el televisor.

En la figura 9 se superponen las tres curvas: la medición de la escena, su conversión en valores digitales y los valores de brillo en el monitor y cómo cambian los mismos, en amarillo los cambios de las cd/m2 medidas a los cv y de estos (en azul) a los nits del monitor, tomando como referencia tres valores, blanco, gris medio y negro.

Figura 9

Observamos que el valor del gris medio coincide aproximadamente en la luminancia medida de la cuña en el espacio real y los nits medidos en el monitor Flanders, digamos que la zona V corresponde al mismo valor de luminancia en ambos casos.

Hacia las altas luces los valores de luminancia ya no se corresponden sino hasta la zona IX que son parecidos, sin embargo, en los valores que van de la zona VI a la zona VIII los valores de luminancia cambian considerablemente, así por ejemplo la muestra 10 dentro de la zona VI en la medición de la cuña real tiene un valor de 33 cd/m2 mientras que en el monitor la muestra corresponde a un valor de 90 nits,. Si consideramos las zonas desde la medición de la cuña real, entonces el valor de la medición en el monitor caería en la zona VIII, estableciendo valores de luminancia similares entre ambos ámbitos. Si las zonas las consideramos desde la perspectiva del monitor, entonces la zona VI del monitor equivaldría en luminancia a la zona VIII de la cuña real. Entre los valores de luminancia de ambos ámbitos hacia las altas luces hay una diferencia de dos zonas, lo que una es zona VI en otra es zona VIII. Intentamos averiguar que correlación en valores de luminancia, hay entre el espacio real y su representación en un monitor pasando por un proceso determinado y lo más transparente posible.

En las sombras también hay cambios en las relaciones de luminancia de ambos ámbitos. Por ejemplo, la muestra 26 en la zona I de la cuña real muestra una valor de 2.9 cd/m2 mientras que el monitor es de 0,3 nits, prácticamente de la zona 0 a la zona III de la cuña real permanece muy oscuro en el monitor.

Así el monitor Flanders presenta un mayor contraste, con negros más oscuros y menos detalle y blancos más luminosos que la cuña. Este mismo ejercicio lo hemos realizado con el TVlogic HDR con resultados diferentes como era de esperar. Si bien con este ejercicio puedo conocer como será la luminancia y el detalle mostrado en un monitor dado, con una curva de gamma dada y sin procesos de colorización de la escena que fotografío, es decir, cómo será la relación de contraste de la escena y su visualización. La pregunta es ¿se puede establecer un patrón que responda al sistema de zonas tradicional que permita prever el resultado de una imagen en un monitor dado? A mi entender y después de todos estos ejercicios la respuesta es no. Y además ¿Qué interés puede tener trabajar de esta manera, o qué ventajas ofrece? Si damos un paso más veremos que la realidad a la hora de trabajar con nuestras imágenes digitales es mucho más compleja y las variables se multiplican.

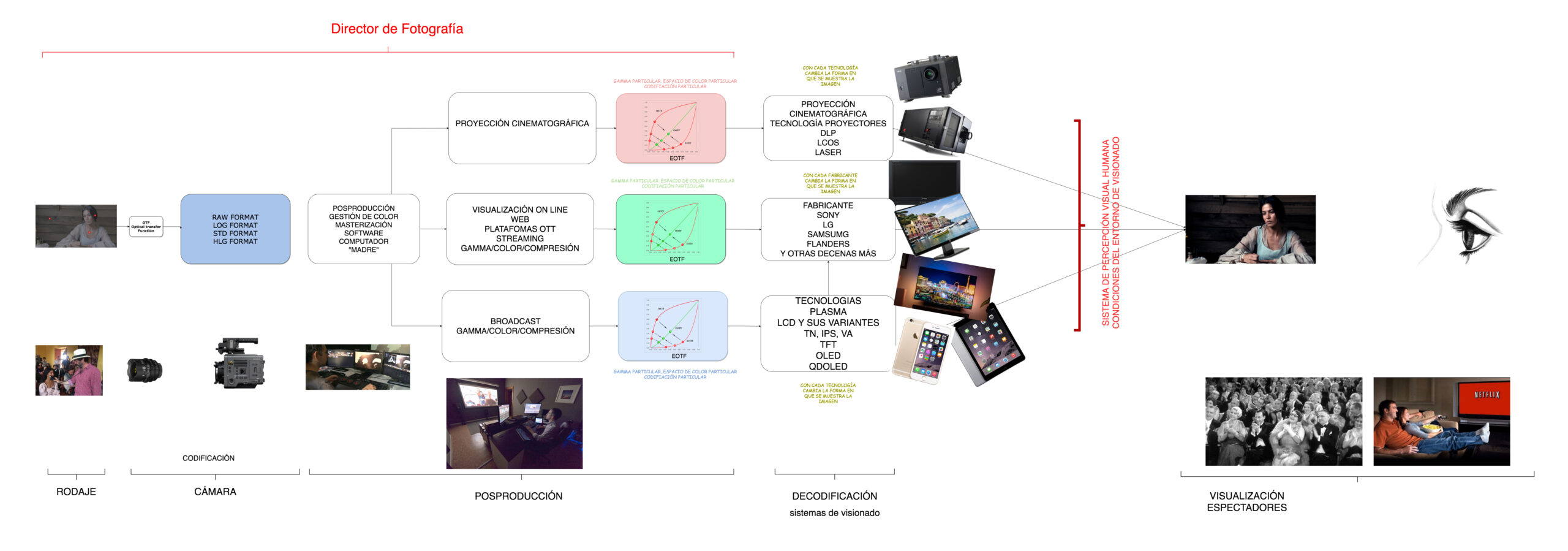

Figura 10

Los valores que medimos en la escena y que vemos finalmente en la pantalla o cualquier otro medio de visualización, está determinado por todo lo que el diagrama muestra. Primero la cámara, con sus distintas curvas de gamma, (algo así como si en analógico cambiamos la emulsión o los procesos de revelado) funciones de transferencia, etc., sus diferentes archivos de codificación con o sin compresión, luego la transformación que hace el sistema de gestión de color para trabajar la imagen en sus múltiples facetas: color, resolución, exposición, ruido o geometría además de los distintos proceso para la visualización final, si es para proyección cinematográfica, si es para OTTS, web o broadcast y además hay que sumarle que los monitores, proyectores, tabletas o teléfonos tienen distintas tecnologías y por lo tanto nuestra imagen se ve diferente en cada uno de ellos, incluso cuando dos fabricantes utilizan la misma tecnología aparecen diferencias. Sin olvidar, nuestra propia visión y el entorno en que observamos la imagen (figura 10). Todo ello afecta a nuestro sistema de zonas, por ejemplo, la “plasticidad” del formato digital permite que en colorización podamos modificar las zonas, de tal manera que la zona V de la escena rodada puede acabar siendo zona III o que la zona X puede terminar siendo zona VII. Lo parámetros son tantos y tan complejos que mantener una consistencia de las zonas a lo largo de todo el flujo resulta prácticamente imposible, pero además ¿es necesario? Como directores de fotografía podemos controlar (aunque no siempre) los procesos que van desde el rodaje hasta la masterización, pero más allá de eso el terreno es ignoto, a pesar de los intentos repetidos una y otra vez por establecer mecanismos que permitan que el espectador vea las imágenes tal cual las concebimos y creamos.

Si recordamos el principal objetivo del sistema de zonas expuesto al comienzo del articulo que es la de prever el contraste de mi copia positiva final ¿Qué necesidad tenemos de hacer eso cuando en el mundo digital de forma inmediata estamos viendo esa transcripción en un monitor o una pantalla o su representación en un wfm? En realidad, en el mundo digital no necesitamos prever como se verá la imagen, aunque si debemos conocer todos los procesos involucrados para tener un control de la fotografía a lo largo del proceso de creación, manipulación y exhibición. La complejidad de las variables que intervienen en la creación de la imagen digital, así como la inmediatez y plasticidad del sistema hace, a mi juicio, innecesario trabajar con un sistema de zonas entendido este como fue creado por el mundo analógico allá por finales de los años 30 del siglo pasado.

Tanta vuelta y tanto gráfico para llegar a tal conclusión, sí, pero…hay algo que podemos rescatar de aquel sistema y es el marco conceptual de evaluar la exposición considerando zonas de la imagen, en su relación de luminancia y por tanto del detalle que pueden mostrar, sea de una forma u otra tras los procesos a los que sometemos la imagen; porque hay que decir, pese a lo mostrado anteriormente, que el mundo digital cinematográfico tampoco es el salvaje oeste, donde no hay ley, al contrario, hay muchas “leyes”, de hecho hay estándares, normas y descripciones de los procesos sujetos a organizaciones internacionales, aunque las normas se interpretan y modifican según fabricantes y tecnologías.

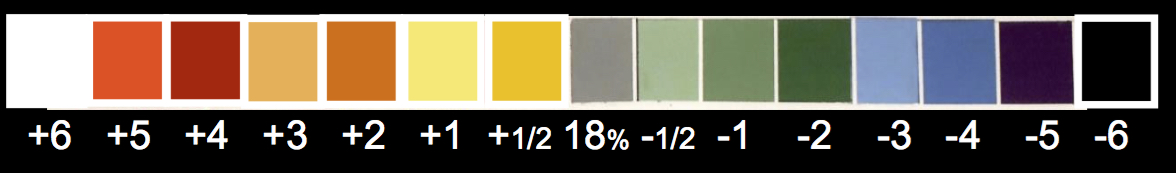

A la hora de calcular nuestras exposición tenemos en cuenta las relaciones de contraste de la escena, entre otras muchas variables, y con ello determinamos la atmósfera que esta presenta, cómo la cámara la captura y cómo el monitor la representa. Con la tecnología analógica podemos medir mediante un spot meter distintas áreas de la escena comparando sus valores y estableciendo así las distintas relaciones no solo en la luminancia sino también en el detalle que cada zona deja ver, todo ello acomodado a la curva sensitométrica propia de cada emulsión (tanto el negativo como el positivo). La medida que normalmente los directores de fotografía hemos usado para estar relación es la escala de los diafragmas (valores F) aunque también se pueden utilizar valores ev o cd/m2 . Podemos hacer algo parecido en el mundo digital, que es medir los diferentes valores de luminancia de la escena en relación a la curva de gamma y su rango dinámico. Con la llegada de la cinematografía digital se asoma a nuestro mundo las señales de vídeo y los histogramas. La imagen capturada por la cámara se muestra en forma de una señal que se mide en valores mv(milivoltio) o ire, algo que resulta ajeno a la cinematografía y con las cámaras digitales de fotografía llegó el histograma, algún aún más alejado de nuestra forma de medir. No obstante, nos hemos ido acostumbrado a manejar los monitores de ondas, vectorscopios e histogramas sin obtener aún de los fabricantes que introduzcan escalas de F stop en sus aparatos. Por eso quiero reseñar aquí el sistema False Color adaptado a los número F diseñado por Ed Lachman y Barry Russo. Este sistema se representa igual que un false color tradicional solo que sus valores de medición no son valores IRE sino F stop y permite representar unas 15 zonas frente a las 6 o 7 que utiliza el false color habitual, lo cual lo hace mucho más preciso a la hora de evaluar la exposición y el rango de contraste de la escena. Al aplicarlo nuestra imagen aparece con una serie de colores y cada uno de ellos corresponde a un F stop determinado en relación al gris 18% valor de referencia en el mundo de la cinematografía (2) (figura 11)

Figura 11

Esta forma de evaluar la exposición a través directamente de la cámara (un auténtico spot meter) está actualmente implementado en las cámaras Panasonic y a la espera que otros fabricantes la adopten. Tenemos que considerar que estos valores/colores están en intima relación con las curvas de gamma que se apliquen y por tanto al rango dinámico que está permite. Con la variación de las curvas de gamma varían los valores (cv) aunque no la relación absoluta entre los distintos tonos que siempre representan la misma diferencia de valor.

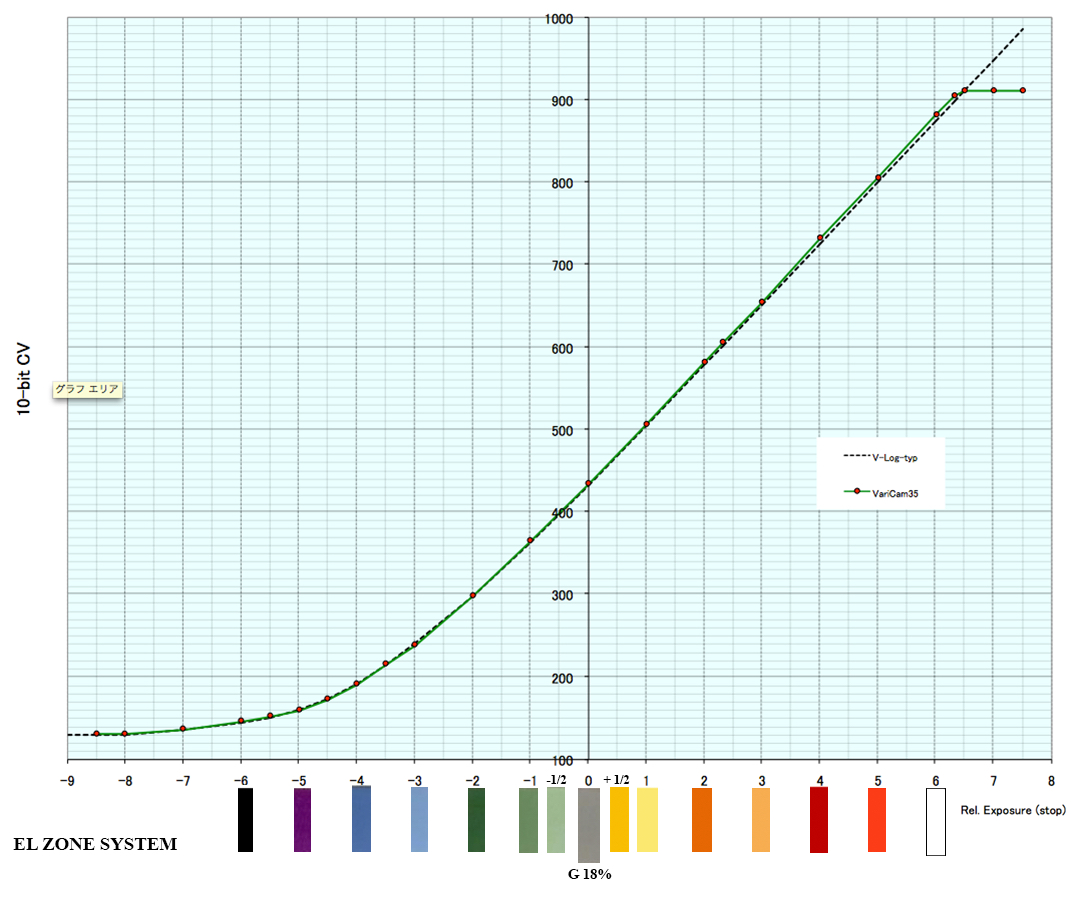

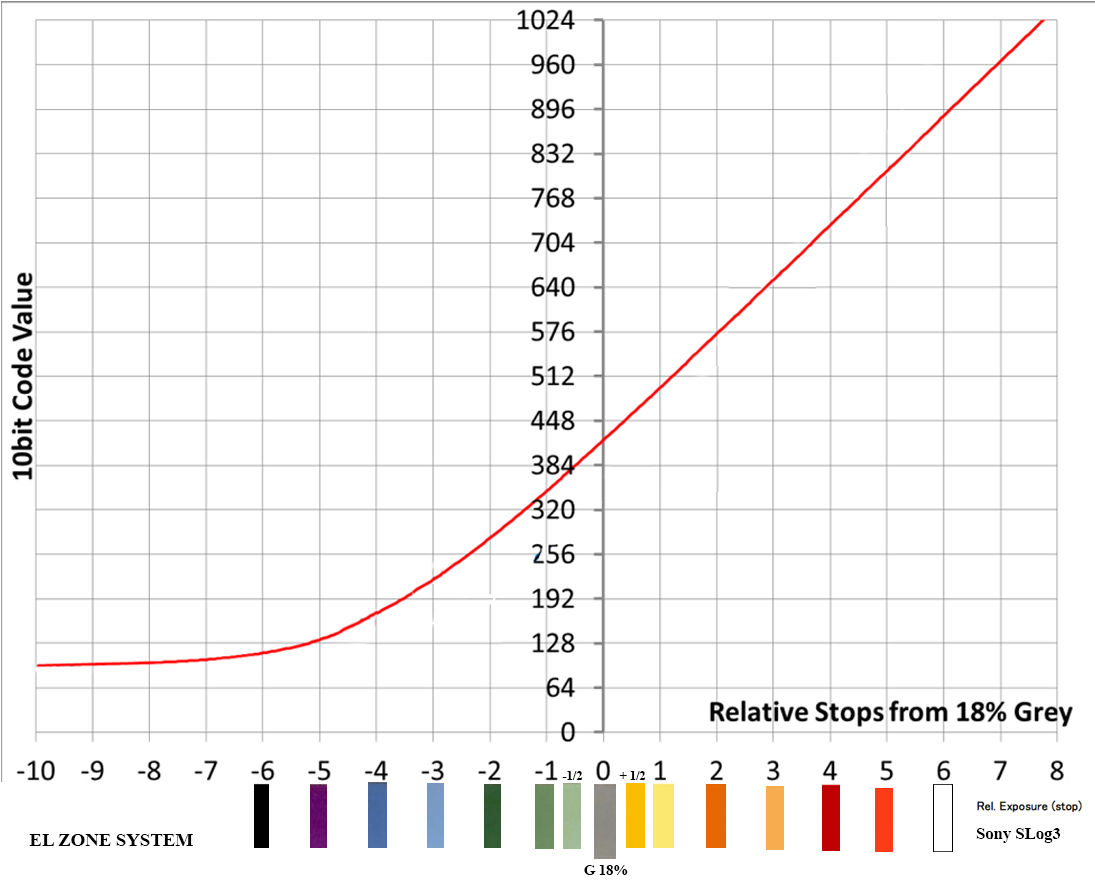

Figura 12

En la figura 12 se puede comprobar la diferencia de código (cv) entre la curva de la varicam de panasonic (izquierda) y la curva Slog3 de Sony (derecha). En el eje horizontal los f stop y el vertical los cv en 10 bits.

Cada curva de gamma de cada fabricante mostrara así ligeras diferencias de luminosidad en los monitores o lo que es lo mismo una variación en las zonas. La zona V es diferente para Canon que, para Sony, Red, Arri o Panasonic y dentro de cada fabricante lo es también para las distintas curvas de gamma que manejan (figura 13)

Figura 13

De nuevo el sistema de zonas tradicional queda en entre dicho ante la diversidad de variables que intervienen en la creación de la imagen digital. Fijémonos que el sistema EL no es tanto un sistema como una forma de visualizar la relación de contraste de la escena, mediante el uso de un False Color sofisticado y que utiliza los F stop como referencia de medida, es por lo tanto, una herramienta para exponer, en el mismo sentido que puede serlo un wfm o un histograma. El sistema de evaluación de la exposición EL viene a llenar una aspiración de los directores de fotografía de poder medir en el mundo digital como lo hemos hecho en el mundo analógico, con el mismo concepto.

En resumen, podría señalar que la rigidez del sistema de zonas tradicional, casa mal con la inmediatez, versatilidad y diversidad de los entornos digitales y que no tiene una aplicación efectiva y necesaria en el mundo de la cinematografía digital si bien su marco conceptual sigue teniendo validez a la hora de exponer y pensar la imagen como un todo donde se conjugan mediante la división en zonas de la escena los procesos de iluminación, captura de la imagen, su procesado y finalmente su proyección.

(1) The Practical Zone System for fim and digital Photography. Chris Johnson. Focal press. Traducción propia

(2) Las imágenes de sistema de EL son cortesía de Ed Lachman y Barry Russo.

Referencias:

-The Practical Zone System for fim and digital Photography. Chris Johnson. Focal press

-Report ITU-R Bt.2390-3 (10/2017)

-Handbook of Signal Processing Systems

Shuvra S. Bhattacharyya, Ed F. Deprettere, Rainer Leupers, Jarmo Takala

Springer, 13/10/2018

– Sistema de zonas en fotografía digital. Francisco Bernal Rosso

– El sistema de zonas. Control del tono fotográfico. Manolo Laguillo. Photovision

Agradecimientos: Adriana Bernal, Juan Pablo Bonilla, José Guardia, Jorge Igual, Philippe Ros y los miembros del ITC de IMAGO. A todos ellos mi agradecimiento por su tiempo, en la lectura del texto y sus oportunos comentarios al mismo.

Han colaborado:

Alfonso Parra © 2022